Sensores de visión artificial:

cómo ven el mundo las máquinas

La fabricación implica abastecerse de las piezas adecuadas, encontrar una fábrica apropiada, llevar sus diseños a la línea de ensamblado a tiempo y sortear las dificultades de conformidad y seguridad necesarias para llegar a escala mundial.

Es deseable emplear la tecnología de automatización para mejorar las líneas de producción de fabricación y sus productos con gran eficiencia. Las señales visuales son la fuente más rica de información de los sensores. El desarrollo de la visión en la fabricación se traduce en mejoras en la fiabilidad y la calidad de los productos, y hace posible la tecnología para un nuevo proceso de producción. Hablaremos sobre cómo se usa la visión artificial en la automatización industrial para facilitar el proceso de fabricación.

En la automatización de fábricas, se usan sensores para recoger datos con el fin de inspeccionar o para activar otros dispositivos. Estos sensores se dividen en varias categorías. Los más comunes son los fotoeléctricos, de fibra óptica, de proximidad, ultrasónicos y de visión. Como estos sensores no pueden distinguir entre patrones o colores, con su configuración de montaje rígida, no pueden manejar bien la falta de alineación ni la variabilidad. Los sensores de visión desempeñan un papel diferenciador que ofrece mayor flexibilidad, realizan múltiples tipos de inspección con una sola imagen y generan valiosos datos adicionales para mejorar la calidad y los procesos.

Fusión de sensores

Los desarrolladores de automatización necesitan una amplia gama de sensores que proporcionen datos brutos y retroalimentación, sistemas de control, lógica programable y dispositivos embebidos conectados. Los datos los analiza un algoritmo y no una persona, lo que presenta la oportunidad de introducir diferentes modalidades de detección en los sistemas de visión artificial. Eso puede incluir modalidades distintas a los sensores de imágenes, como tiempo de vuelo, radar y Lidar, con lo que surge la necesidad de fusionar los sensores. La fusión de sensores es el proceso de tomar datos de múltiples fuentes y combinarlos en un único conjunto que pueda introducirse en una red neuronal. Se trata de una etapa crucial, porque la forma en que se ponderen los datos de cada sensor influirá en su relevancia en el conjunto de datos final.

Sistemas de visión artificial

La visión por ordenador es el campo de la inteligencia artificial (IA) que permite a las máquinas "ver". La combinación de los sistemas embebidos con la visión por ordenador da como resultado los sistemas de visión embebida/artificial. La tecnología de visión artificial está bien posicionada en el Internet industrial de las cosas (IIoT), donde se conectan constantemente máquinas de todo tipo. La visión artificial se está adoptando tan rápidamente en las aplicaciones IIoT debido a la creciente asequibilidad de los componentes y sistemas de visión artificial, a una gama más amplia de soluciones, a un mejor hardware y al software basado en IA para el aprendizaje profundo. El sistema de visión artificial tiene la capacidad de procesar una gran cantidad de información en una fracción de segundo.

A grandes rasgos, los distintos tipos de sistemas de visión incluyen los sistemas de visión 1D y 2D, los escáneres lineales o de área y los sistemas de visión 3D. Los principales bloques funcionales de un sistema de visión típico (Figura 1) son una unidad de adquisición de imágenes (sensor de imagen/módulo de cámara), unidad de procesamiento, segmentación y software y algoritmos de visión/reconocimiento de patrones y conectividad.

Figura 1: Bloques fundamentales de la visión artificial

La visión artificial usa cámaras como ojos que captan la información visual del entorno circundante. La resolución y la sensibilidad son dos aspectos importantes de cualquier sistema de visión artificial. La resolución se encarga de diferenciar los objetos, mientras que la sensibilidad es la capacidad de la máquina para detectar objetos o pulsos débiles pese a luces tenues o longitudes de onda invisibles.

Los principales componentes del sistema son la iluminación, el objetivo, los sensores de imagen, el procesamiento de la visión y los dispositivos de comunicación, y a menudo se emplean ópticas especializadas para adquirir las imágenes. La tecnología de visión artificial es una combinación de software y hardware que da control operativo a los dispositivos que ejecutan funciones como la captura y el procesamiento de imágenes y la medición de diversas características necesarias para la toma de decisiones. Los componentes de hardware abarcan varios objetos como cámaras, sensores, procesadores, captura de fotogramas, iluminación LED y ópticos. El segmento de la oferta de software se divide en subcategorías de software de visión artificial para aplicaciones específicas y software de visión artificial de aprendizaje profundo.

Los proveedores de sistemas de visión artificial ofrecen principalmente dos tipos de servicios: integración y gestión de soluciones. Los integradores de sistemas de visión artificial se usan para aplicaciones de inspección, pruebas, ensamblaje y calibrado y ayudan a los clientes a cumplir las especificaciones de sus productos. La gestión de soluciones se usa para operaciones de depuración de un solo paso, control de inspección (arranque y parada) y soluciones de abrir y guardar.

Cómo elegir el hardware adecuado

Existen muchas opciones a la hora de decidir el hardware que ejecutará su aplicación de IA de visión artificial. Los arrays de puertas programables en campo (FPGA), las unidades de procesamiento gráfico (GPU) e incluso los microcontroladores (MCU) tienen cada uno sus propias ventajas.

Las FPGA son unidades de procesamiento muy potentes que se pueden configurar para satisfacer los requisitos de casi cualquier aplicación. Se pueden crear arquitecturas de FPGA a medida para manejar aplicaciones específicas. Las FPGA tienen un rendimiento mucho mayor, costes más bajos y mayor eficiencia energética en comparación con otras opciones como las GPU y las CPU. Las GPU son procesadores especializados diseñados principalmente para procesar imágenes y vídeos. En comparación con las CPU, se basan en unidades de procesamiento más simples pero con un número mucho mayor de núcleos. Esto hace que las GPU sean excelentes para aplicaciones en las que es necesario procesar grandes cantidades de datos de forma paralela, como los píxeles de imágenes o los codecs de vídeo. Las CPU tienen un número limitado de núcleos, lo que inhibe su capacidad para procesar rápidamente las grandes cantidades de datos necesarias para la IA.

Sensor de imagen e iluminación

Al desarrollar un sistema de visión artificial, la selección del sensor de imagen adecuado puede ser una de las decisiones de diseño más importantes. El diseño requiere la captura de imágenes de alta resolución, transferencia de datos rápida con ruido mínimo y potencia de procesamiento eficiente capaz de preparar los datos para el análisis y generar salidas. Los avances en la iluminación frontal (FSI) y trasera (BSI) de la tecnología de sensores CMOS permiten obtener imágenes de mayor resolución con poca luz.

También es importante la iluminación adecuada. La base de la totalidad del rendimiento de la iluminación se reduce a tres características principales del sensor de imagen: la eficiencia cuántica (QE), la corriente oscura y la capacidad de saturación. Cuando se implementa en una cámara, la QE máxima de ésta debe ser inferior a la del sensor, debido a los efectos ópticos y electrónicos externos.

La corriente oscura y la capacidad de saturación son también importantes en el diseño de los sistemas de visión artificial. La corriente oscura mide la variación en el número de electrones generados térmicamente dentro del sensor de imágenes CMOS y puede añadir ruido. La capacidad de saturación denota el número de electrones que puede almacenar un píxel individual. Se pueden usarse junto con medidas de QE para obtener la relación señal/ruido (S/N) máxima, la sensibilidad absoluta y el rango dinámico de una aplicación.

La iluminación adecuada contribuirá a aumentar la precisión y la eficiencia de una aplicación de visión artificial. Otros factores que se deben tener en cuenta junto con la iluminación incluyen la longitud de onda (como los infrarrojos), la iluminación fija e incluso la colocación de la iluminación. Se ha demostrado que las fuentes de luz y los reflejos que brillan directamente sobre las cámaras de los sistemas de visión artificial disminuyen la precisión en la detección de los objetos.

Cómo elegir la cámara de visión artificial adecuada

Los avances recientes en la tecnología de visión artificial ahora permiten a las cámaras transferir imágenes de altos megapíxeles a tasas de fotogramas muy rápidas. Para la selección de la mejor interfaz es necesario revisar varias consideraciones, como la elección del tipo de sensor (CMOS o CCD), la cámara a color o monocromo, el formato de salida de la cámara (GigE, Camera Link, CoaXPress, USB3, HD-SDI) y la tasa de fotogramas. Los CCD tienen mejor calidad de imagen, mejor sensibilidad a la luz, mayor rendimiento frente al ruido y un obturador global ideal. Los sensores CMOS son conocidos por su alta velocidad, la integración del sistema en el chip y su bajo coste de fabricación.

Los fabricantes de cámaras aprovechan los avances más recientes en sensores y las mejoras en el diseño de las cámaras para ayudar a los desarrolladores e integradores de sistemas de visión artificial a crear sistemas de captura de imágenes más rápidos, flexibles y capaces. Las mayores resoluciones de cámara conllevan la necesidad de ópticas de mayor calidad y de formato más grande fácilmente disponibles, con opciones que incluyen lentes líquidas integradas para sistemas de autoenfoque. La óptica para longitudes de onda no visibles hace posibles nuevas formas de detectar cosas con imágenes especializadas que usan longitudes de onda que van desde el ultravioleta hasta las bandas de infrarrojo.

Los productos de iluminación LED, cruciales para todas las aplicaciones de visión artificial, ahora vienen en una amplia variedad de longitudes de onda y factores de forma. Tienen mayor flexibilidad, con ángulos ajustables y longitudes de onda adicionales, una respuesta espectral más consistente e incluso fuentes programables con controles embebidos. Un factor importante es el surgimiento de interfaces de hasta 100 G, así como la interfaz CoaXPress 2.0 recientemente actualizada e incluso interfaces PCI.

Cómo elegir un objetivo de visión artificial

Decidir cuál es el objetivo (lente) adecuado para una aplicación de visión artificial exige revisar las especificaciones requeridas, hacer algunos cálculos y pensar cómo se integrará el objetivo con la configuración de la cámara. A la hora de elegir el objetivo de una aplicación de visión artificial, hay que tener en cuenta el sensor que se va a utilizar. Los tamaños del sensor y de los píxeles son de extrema importancia en el proceso de selección. El objetivo debe poder iluminar correctamente toda la zona del sensor para evitar el sombreado y el viñeteado.

Los objetivos ideales producen imágenes que se ajustan perfectamente al objeto capturado, incluidos todos los detalles y variaciones de brillo. Los objetivos estándar pueden tener cerca de un megapíxel en distancias focales fijas de 4,5 a 100 mm. Los objetivos macro están optimizados para enfocar de cerca. Al seleccionar el objetivo adecuado para una aplicación, los diseñadores usan 3 factores para calcular la distancia de funcionamiento necesaria: la distancia focal, la longitud del objeto inspeccionado y el tamaño del sensor.

Algunos de los casos de uso/escenarios de aplicación

Los sistemas de visión artificial en el sector de alimentos y bebidas se usan de forma destacada en las operaciones de empacado y embotellado. Es probable que los sistemas de visión artificial experimenten un crecimiento significativo en los sectores farmacéutico y químico, de impresión y etiquetado, y en otros nichos, como la agricultura, el procesamiento de caucho y plástico, los paneles solares, la maquinaria y el equipamiento, la seguridad y la vigilancia. El mercado se ha dividido en los segmentos de control de calidad e inspección, posicionamiento y orientación, medición e identificación. Los sistemas se usan ampliamente para escanear e identificar etiquetas, códigos de barras y textos, en especial en el sector del empaquetado. Esto automatiza las actividades de empaquetado, con lo que se ahorra tiempo, se evitan errores humanos y se aumenta la eficacia.

Las soluciones de visión artificial hacen que los procesos de fabricación sean más eficientes y competitivos. Las cámaras de visión artificial funcionan a la perfección en una amplia gama de entornos de fabricación. La Figura 2 a continuación muestra el bloque de aplicación típico.

Figura 2: Bloque de aplicación típico para visión artificial

Plataforma de visión inteligente Avnet Integrated

Avnet ha desarrollado plataformas de desarrollo modulares específicas para la visión embebida, que combinan cámaras inteligentes, tecnologías informáticas basadas en la periferia o en la nube, software e inteligencia artificial para crear sistemas capaces de detectar e identificar personas y objetos. La plataforma de tecnología de visión inteligente Avnet Integrated (Figura 3) está diseñada para el análisis periférico de vídeo apoyado en el aprendizaje profundo. En este diseño han colaborado los principales fabricantes de procesadores, sensores de imagen y herramientas de software para integrar sus productos en una solución cohesiva.

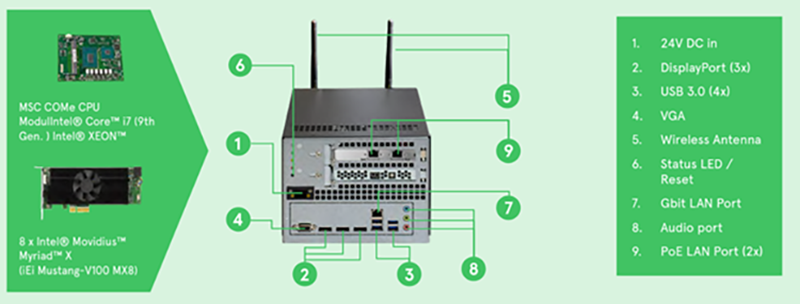

Figura 3: Plataforma de visión con tecnología de IA de Avnet: Infinity® AI Cube

Para estas aplicaciones de alto rendimiento, la plataforma de visión inteligente está equipada con el potentísimo módulo COM Express™ Tipo 6 de la gama MSC C6B-CFLR de Avnet Integrated, que se basa en un procesador Intel® Core i7 o Intel® Xeon™.

La plataforma tecnológica puede integrar varias tecnologías de acelerador para el procesamiento rápido de los datos en la periferia. El número de canales de vídeo y el tiempo de latencia desempeñan un papel dependiendo de la aplicación específica. Las soluciones van desde la inferencia de IA en potentes CPU, unidades de procesamiento gráfico hasta las unidades de procesamiento de visión (VPU) Intel® Movidius optimizadas.